La inteligencia artificial (IA) está por todas partes: recomienda lo que ves en redes, decide si te aprueban un crédito, filtra tu currículum en un proceso de selección… y si no tienes cuidado, también te discrimina sin pestañear. Porque sí, aunque suene irónico, los sistemas que deberían ser “objetivos” pueden terminar replicando (o incluso amplificando) los mismos sesgos que las personas han intentado dejar atrás.

Ahora bien, no se trata de cancelar a los algoritmos ni exiliarlos a un rincón oscuro del ciberespacio. Se trata de entender por qué discriminan, cómo lo hacen y qué podemos hacer para evitarlo. Spoiler: sí hay soluciones, pero requieren esfuerzo, conciencia y, por supuesto, una buena dosis de ética digital.

Los algoritmos no odian a nadie… pero aprenden de quienes sí

Una IA no se levanta un lunes diciendo “Hoy voy a discriminar”. Lo que hace es aprender de los datos que se le dan. Y si esos datos reflejan una sociedad desigual, adivina qué tipo de decisiones tomará.

Por ejemplo: si se entrena un sistema de contratación con historiales laborales donde las mujeres fueron históricamente descartadas de puestos técnicos, el algoritmo entenderá que ser mujer equivale a “no apta”. No es malicia, es estadística… mal gestionada.

Así nacen los sesgos algorítmicos: cuando los modelos aprenden patrones problemáticos y los perpetúan sin cuestionarlos. Por eso es tan importante revisar, limpiar y equilibrar los datos antes de alimentar a una IA con ellos. Porque si le das basura, obtendrás decisiones… basura (pero con etiqueta “inteligente”).

¿Dónde ocurre la discriminación algorítmica?

Spoiler: en casi todos lados. Algunos ejemplos reales que te harán levantar una ceja (o las dos):

- Recursos humanos: IA que penaliza currículums con nombres “extranjeros” o con género femenino.

- Créditos bancarios: modelos que otorgan menos préstamos a comunidades racializadas o a barrios pobres.

- Justicia predictiva: algoritmos que etiquetan a ciertas personas como “más propensas a reincidir” solo por su perfil demográfico.

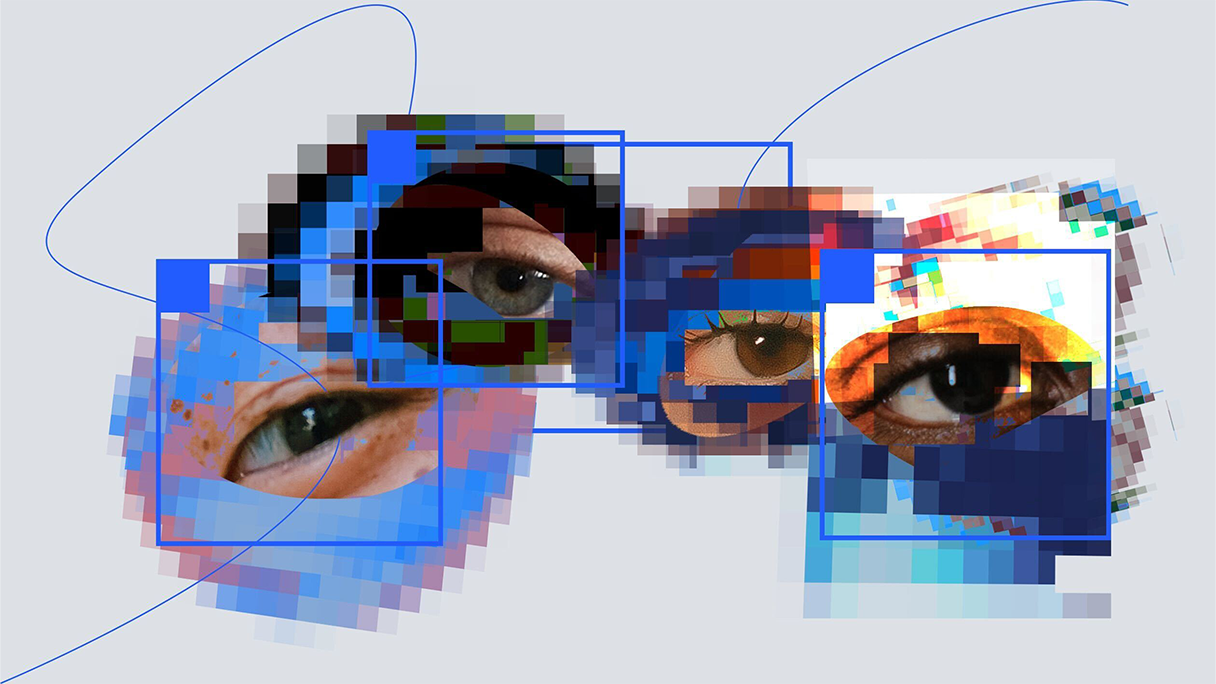

- Reconocimiento facial: sistemas que fallan mucho más en personas con piel oscura o rasgos asiáticos.

Lo preocupante no es solo que esto ocurra. Lo verdaderamente alarmante es que muchas veces pasa sin que nadie lo sepa, porque los sistemas no son transparentes y las personas afectadas no pueden defenderse.

El sesgo no se elimina con buena voluntad

Decir “mi modelo es imparcial” es como decir “mi perro nunca muerde” justo antes de que le ladre a tu visita. La imparcialidad en IA no es una declaración de intenciones: es el resultado de procesos concretos para identificar y corregir sesgos.

¿Qué se puede hacer?

- Auditoría de datos: revisar si los datos de entrenamiento tienen representación justa de todos los grupos. Spoiler: casi siempre no la tienen.

- Pruebas de equidad: verificar si el modelo produce resultados diferentes según edad, género, raza, etc.

- Explicabilidad: entender por qué el modelo toma una decisión. Porque si no puedes explicarlo, ¿cómo sabes que no está discriminando?

- Intervención humana: no todo se puede dejar en manos del algoritmo. A veces, un poco de juicio humano hace toda la diferencia.

Ingeniería social para ingenieros: diseño responsable desde el código

No basta con “parchar” los sesgos una vez que aparecen. Hay que diseñar la IA con enfoque ético desde el inicio. ¿Cómo se logra?

- Involucrando equipos diversos en el desarrollo (sí, diversidad en serio, no solo en las fotos de la web).

- Aplicando principios de justicia algorítmica, como la equidad de resultados, la proporcionalidad o el impacto diferenciado.

- Preguntando constantemente: “¿a quién podría perjudicar esto y cómo lo sabremos?”

La ética no es un accesorio techie. Es parte del diseño. Y si no estás construyendo sistemas justos, estás construyendo sistemas injustos. No hay mucho punto medio.

Marco legal y regulaciones: porque la IA también necesita reglas

Aunque los desarrolladores tienen responsabilidad, no se puede dejar todo a la buena voluntad. Se necesitan leyes claras que prohíban la discriminación algorítmica, exijan transparencia y permitan que las personas afectadas puedan apelar decisiones automáticas.

En la Unión Europea, la Ley de Inteligencia Artificial (AI Act) empieza a marcar el camino. Otros países aún están en modo “exploratorio”. Pero lo importante es que haya normas que obliguen a las empresas a auditar sus sistemas y a rendir cuentas si algo sale mal.

Porque la tecnología sin regulación es como un dron con metralleta y sin control remoto: puede hacer mucho daño sin que nadie lo detenga.

El usuario también tiene un rol

Sí, tú. Aunque no diseñes modelos ni trabajes en IA, también puedes ayudar a evitar la discriminación:

- Cuestiona cómo y por qué una plataforma toma decisiones.

- Exige transparencia en los servicios que usas.

- Denuncia si crees que fuiste discriminado por un sistema automático.

- Apoya iniciativas que promuevan una IA ética y justa.

No eres solo un consumidor pasivo. Eres parte del ecosistema digital. Y si no alzas la voz, los algoritmos seguirán haciendo de las suyas sin supervisión.

La IA puede ser justa, pero no lo es por defecto

La inteligencia artificial tiene el potencial de transformar nuestras sociedades, mejorar servicios, eliminar barreras… pero también puede amplificar injusticias con una eficiencia alarmante.

Evitar la discriminación en los sistemas de IA no es una opción decorativa, es una obligación ética, técnica y social. Y requiere trabajo de todos: desarrolladores, gobiernos, empresas y usuarios.

Así que la próxima vez que escuches que un algoritmo “es neutral”, recuerda: neutral es el café sin azúcar. La IA, si no se diseña bien, puede tener más prejuicios que un tío en la cena de Navidad.