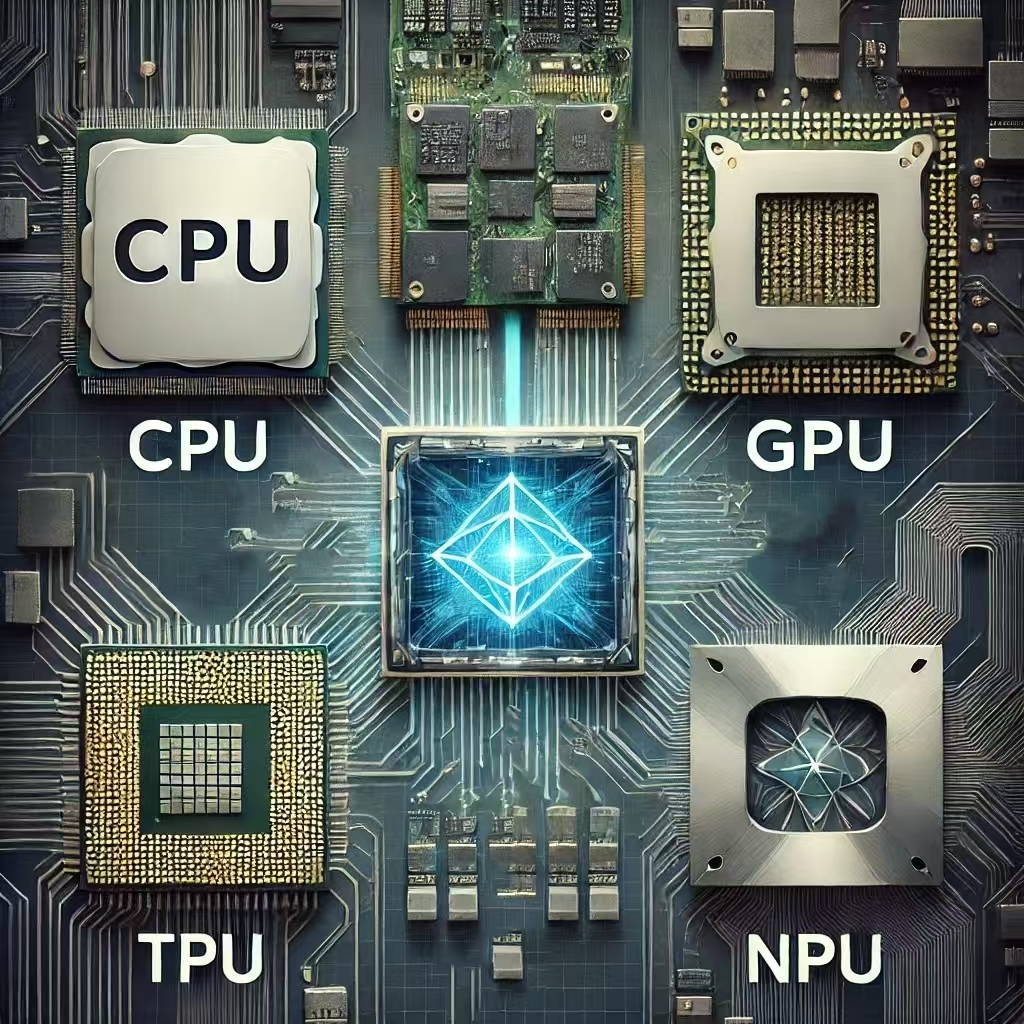

El hardware de computación ha evolucionado para adaptarse a diferentes cargas de trabajo, especialmente en IA y procesamiento intensivo. Esta tabla resume las principales diferencias:

| Característica | CPU (Unidad Central de Procesamiento) | GPU (Unidad de Procesamiento Gráfico) | TPU (Unidad de Procesamiento Tensorial) | NPU (Unidad de Procesamiento Neuronal) |

|---|---|---|---|---|

| Diseño Principal | Procesamiento secuencial (few cores) | Paralelismo masivo (thousands of cores) | Matriz de multiplicadores especializados | Arquitectura optimizada para redes neuronales |

| Enfoque | Propósito general | Gráficos/Computación paralela | Operaciones matriciales (IA/ML) | Inferencia de IA en dispositivos edge |

| Precisión | Alto (FP64) | Media-Alta (FP32/FP16) | Optimizada para IA (TF32/INT8) | Baja Precisión (INT4/INT8) |

| Velocidad (TFLOPS) | 1-2 (FP64) | 10-100 (FP32) | 100-1000 (BF16/TF32) | 5-50 (INT8) |

| Memoria | Cache grande (MBs) | GDDR6/HBM (GBs) | HBM (High Bandwidth Memory) | SRAM integrada (eficiencia energética) |

| Uso Típico | Sistema operativo, apps generales | Deep Learning, renderizado | Entrenamiento de modelos grandes | Inferencia en smartphones/IoT |

| Fabricantes | Intel, AMD | NVIDIA, AMD | Google (Cloud TPU) | Apple (Neural Engine), Qualcomm, Huawei |

| Consumo Energético | 35-150W | 250-700W | 200-900W | 1-10W |

| Costo Relativo | $ | $$ | $$$$ | $$ |

Explicación Detallada

CPU: El Cerebro Versátil

- Arquitectura: Pocos núcleos (4-64) optimizados para tareas secuenciales complejas.

- Ventaja: Baja latencia, manejo eficiente de bifurcaciones y operaciones diversas.

- Limitación: Poco eficiente para operaciones paralelas masivas.

- Ejemplo: Intel Core i9, AMD Ryzen.

GPU: El Rey del Paralelismo

- Arquitectura: Miles de núcleos pequeños (CUDA cores en NVIDIA) para procesamiento paralelo.

- Ventaja: Acelera operaciones matriciales en DL (Convoluciones, Transformers).

- Desventaja: Consumo energético alto, overkill para inferencia simple.

- Ejemplo: NVIDIA RTX 4090 (24GB GDDR6X), H100 (80GB HBM3).

TPU: El Especialista en IA

- Arquitectura: Systolic Arrays optimizados para multiplicación de matrices (operaciones clave en ML).

- Ventaja: 5-30x más rápido que GPUs en modelos específicos (ej: Transformers).

- Desventaja: Menos flexible (solo en Google Cloud, soporte limitado a TensorFlow/JAX).

- Ejemplo: Google TPU v4 (600+ TFLOPS en BF16).

NPU: IA en el Edge

- Arquitectura: Circuitos dedicados para operaciones de redes neuronales (ej: multiplicación-accumulación).

- Ventaja: Eficiencia energética extrema (ideal para smartphones y IoT).

- Limitación: Precisión reducida, solo para inferencia (no entrenamiento).

- Ejemplo: Apple A17 Pro (17 TOPS), Qualcomm Hexagon.

¿Cuál Elegir?

- Entrenamiento de modelos grandes: TPU (Google Cloud) o GPU (NVIDIA H100/A100).

- Inferencia en servidores: GPU (NVIDIA T4/L4) o TPU.

- Dispositivos móviles/edge: NPU integrada (Apple Neural Engine).

- Tareas generales + light ML: CPU con aceleración AVX-512.

Tendencias Futuras:

- Chips neuromórficos (ej: Intel Loihi) que imitan el cerebro humano.

- Computación cuántica para problemas específicos de optimización.

- Interconexiones ópticas para reducir cuellos de botella en clusters IA.

Este ecosistema diversificado permite equilibrar velocidad, costo y eficiencia energética según las necesidades específicas de cada aplicación de IA.